17 نوفمبر 2024, 10:14 صباحاً

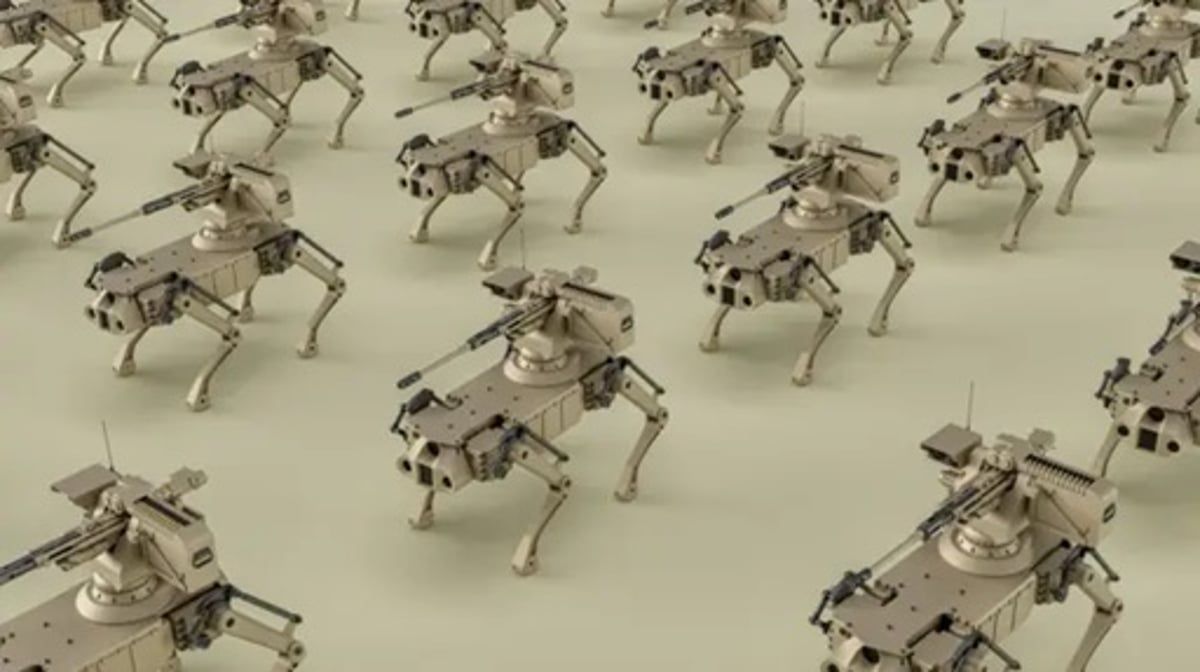

عند سماع مصطلح "الروبوتات القاتلة"، سيتبادر إلى أذهان كثيرين منا أفلام الخيال العلمي التي تصوّر عالماً بائساً يسيطر عليه الذكاء الاصطناعي بآلاته الفتاكة.

ما هي "الروبوتات القاتلة"؟

حسب تقرير على موقع هيئة الإذاعة البريطانية "بي بي سي"، هذا المصطلح بات يُستخدَم لوصف "نُظم الأسلحة المستقلة الفتاكة" التي تعمل بالذكاء الاصطناعي، والتي أصبحت مثار جدلٍ كبيرٍ، ما بين مؤيدٍ يرى أنها ستخفض النفقات العسكرية وتقلل الخسائر المادية والبشرية، ومعارضٍ يرى أنها تنطوي على إشكاليات أخلاقية، وربما تؤدي إلى مزيدٍ من القتل والدمار.

الاستخدام العسكري للذكاء الاصطناعي

تستخدم الجيوش تقنيات الذكاء الاصطناعي في مجالات عدة، منها: تحليل البيانات لاستخراج معلومات استخبارية، والحروب السيبرانية - على سبيل المثال، استخدام تقنية التزييف العميق وروبوتات الذكاء الاصطناعي لنشر دعايات أو معلومات مضللة؛ فضلاً عن اختراق مواقع الإنترنت - وتحديد الأهداف، وتعقب الدبابات والصواريخ والمقاتلات. كما تستخدم في نظم الأسلحة المستقلة الفتاكة، التي ربما تعد الأكثر إثارة للجدل من بين التطبيقات العسكرية لهذه التقنيات.

في الوقت الحالي، يستخدم بعض الجيوش أسلحة شبه مستقلة تسمح بتدخل عناصر بشرية إذا لزم الأمر. لكن ابتكار أسلحة فتاكة مستقلة تماماً قادرة على العمل في المعارك دون أي تدخلٍ بشري يخضع حالياً للتجارب والتطوير في بلدان؛ من بينها الولايات المتحدة والصين وروسيا.

الخوارزميات وخطورة تعلُّم الآلة

الخوارزميات هي أساس الذكاء الاصطناعي، وهي عبارة عن مجموعة من الإرشادات أو القواعد التي يجب أن يستخدمها الكمبيوتر أو الآلة لإنجاز مهمة ما.

و"تعلُّم الآلة" هو أحد أنظمة الذكاء الاصطناعي الذي يبتكر إرشادات خاصّة به سواء من خلال التدريب أو التفاعل مع البيئة بأسلوب التجربة والخطأ، بدلاً من اتباع مجموعة من التعليمات المبرمجة مسبقاً.

المشكلة أن الآلات تواصل التعلُّم بينما نستخدمها في تنفيذ مهمة ما، وطبيعة هذه التقنية تعني أن نظم الذكاء الاصطناعي لا تستجيب بالطريقة ذاتها إذا أدخلت البيانات نفسها مرات عدة، لذا يراها بعضهم نظماً لا يمكن التنبؤ بتصرفاتها. كما أنها عادة ما تكون مثل "الصندوق الأسود": في كثير من الأحيان، من المستحيل أن يفسر المستخدم سبب أو كيفية توصل النظام إلى مخرجات أو نتائج ما بناءً على ما أعطي من مدخلات، أي هناك غياب للشفافية، هذه التقنية مستخدمة بالفعل في نظم الأسلحة المزوّدة بالذكاء الاصطناعي.

المؤيدون للاستخدام العسكري للذكاء الاصطناعي

يقول المؤيدون للاستخدام العسكري للذكاء الاصطناعي، إن استخدام الذكاء الاصطناعي يؤدي إلى تحسين عمليات الاستكشاف والتعرُّف على الأهداف بشكلٍ كبيرٍ، ومن ثم تقليل حجم الدمار الذي تتعرَّض له البنية التحتية المدنية.

يستخدم الخبراء العسكريون الذين يؤيدون استخدام الذكاء الاصطناعي عبارة "force multiplier" ("مضاعِف للقوة")عند وصفه، لأنه سيمكّن الجيوش من تحقيق النتائج التي تسعى إليها بعددٍ أقل من الجند أو المعدات، وهو ما قد يعني تكلفة أقل، ويتغلب على مشكلة ضعف الإقبال على التجنيد التي يواجهها بعض الدول، ومنها الولايات المتحدة.

كما أن نظم الأسلحة المستقلة، برأي المؤيدين، ستؤدي إلى توسيع ساحة المعركة أمام القوات، وتسمح بالوصول إلى مناطق من الصعب الوصول إليها بالطرق التقليدية، وتقلل عدد الخسائر البشرية؛ لأنها ستمكّن القادة من تفادي إرسال الجنود والمقاتلين في مهام خطرة.

ماذا يقول المعارضون؟

يفنّد المعارضون فكرة أنها تبعد الجنود عن مرمى الخطر، حيث يرون أن النتيجة ستكون سهولة اندلاع الحروب؛ فالكلفة البشرية من أهم أسباب عدم خوض القادة للحروب؛ لما تتسبب فيه من سخطٍ شعبي، وتخفيض الخسائر البشرية سيؤدي إلى سهولة اتخاذ قرار الحرب، ومن ثم المزيد من القتل والدمار في المُجمل.

في تصريحاتٍ لـ"بي بي سي عربي"، يقول العالم البريطاني البروفيسور ستيوارت راسل؛ أستاذ علوم الكمبيوتر بجامعة كاليفورنيا في بيركلي، والمعروف بإسهاماته المتميزة في أبحاث الذكاء الاصطناعي، إن ما يُقال بشأن إبعاد الجنود عن مرمى الخطر "هو ما أسميه مغالطة الملكية الوحيدة، لأنك تتخيّل أن لديك أنت وحدك أسلحة تعمل بالذكاء الاصطناعي والطرف الآخر ليست لديه هذه الأسلحة.. امتلاك أسلحة يتم التحكم فيها وتوجيهها عن بُعد من قِبل طرفَي الحرب الأوكرانية أدّى إلى معدلات خسائر بشرية مرتفعة للغاية، إذ إن القنابل الصغيرة التي تلقيها الطائرات المسيّرة تستطيع الوصول إلى أهدافٍ موجودة حتى في الخنادق".

ويضيف أن "الهدف الرئيس للأسلحة المستقلة الفتاكة، كما عكف مجتمع الذكاء الاصطناعي على القول مراراً وعلى مدى عقدٍ من الزمان، هو أن تصبح (وربما يكون ذلك قد بدأ بالفعل) أسلحة دمار شامل رخيصة يمكن إنتاجها بقدرات مختلفة ونشرها بسهولة. ذلك لأنها مستقلة وليست بحاجة إلى إشرافٍ بشري، ما يعني أن شخصاً واحداً يستطيع أن يضغط على زر فيطلق مليون سلاح ليقتل مليون شخص".

ويرى راسل؛ أن "تطوير نظم أسلحة مستقلة فتاكة يحل فيها الذكاء الاصطناعي محل البشر أمرٌ حتمي"، وأن الحرب في أوكرانيا -على سبيل المثال- تسير في هذا الاتجاه بشكلٍ متزايد. ويحذّر من "إمكانية أن نصل إلى مرحلة تكون فيها مثل هذه الأسلحة متاحة لأي جنرالٍ أو ديكتاتورٍ أو إرهابي".

ويرى المعارضون كذلك أن اتخاذ القرار من خلال لوغاريتمات في تلك الأسلحة ربما يؤدي إلى التصعيد السريع، وعدم القدرة على التنبؤ بالنتائج (خاصية "الصندوق الأسود").

ملحوظة: مضمون هذا الخبر تم كتابته بواسطة صحيفة سبق الإلكترونية ولا يعبر عن وجهة نظر مصر اليوم وانما تم نقله بمحتواه كما هو من صحيفة سبق الإلكترونية ونحن غير مسئولين عن محتوى الخبر والعهدة علي المصدر السابق ذكرة.